欢迎来到芯果!

欢迎来到芯果!

算力、算力租赁概念热度不减。到11月9日收盘,目前天威视讯6连板,此前11月8日盘后公告称,公司股票于2023年11月7日、2023年11月8日连续2个交易日收盘价格涨幅偏离值累计达到20%以上,属于股票交易异常波动的情况。近期公司经营情况正常,内外部经营环境未发生重大变化;此外,浪潮信息尾盘放量涨停,成交额突破70亿元。

《上海市推动人工智能大模型创新发展若干措施(2023—2025年)》日前正式发布,《措施》提出,实施大模型智能算力加速计划,打造市级智能算力统筹调度平台,构建规模化先进算力调度和供给能力。

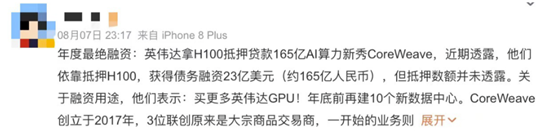

提到算力和算力租赁业务,不得不回到本年度最佳融资结构,非CoreWeave莫属!据悉,投资圈江湖流传的小道消息可以看出,英伟达H100甚至可以作为金融债权“抵押物”,也是一种另类的融资“敲门砖”,初创的科技公司可以依靠自己掌握的H100找到基金获取抵押贷款,也算是算力租赁业务“高光”时刻,突飞猛进。

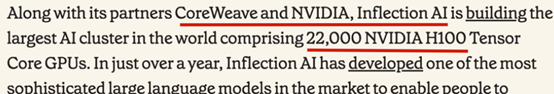

CoreWeave致力于建设全球最大的AI服务器集群。根据目前媒体资讯显示,CoreWeave的目标是运行2.2万块英伟达H100;如果建成,将会超过Meta之前宣布的1.6万块GPU计划,成为全球最大的AI服务器集群。

成立仅仅几年就估值突破80亿美元,筹资23亿美元债务融资,英伟达力挺的CoreWeave究竟是何方神圣?芯片公司巨头英伟达称,在2024财年第二个季度售出价值103亿美元的芯片,据市场研究公司Omdia估计,英伟达H100 GPU出货量超过816吨(没错,单位是吨)。面对如此庞大的芯片量数据,全球芯片荒的现象仍未得到缓解。时至今日,H100早已一卡难求。

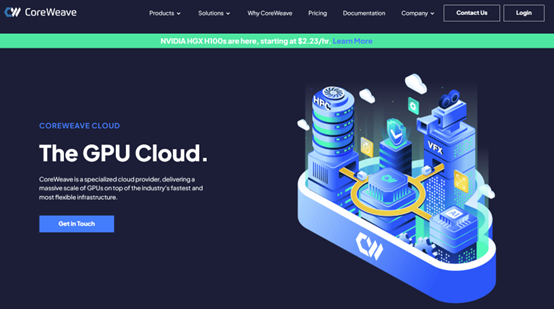

CoreWeave将自己定位于一家专门为企业规模的GPU加速工作负载提供云服务的提供商。它的业务模式是基础设施即服务,按小时出租GPU,客户只需要按使用时间和计算资源量来支付费用。根据CoreWeave官网的介绍,其云服务包括NVIDIA HGX H100 GPU计算、CPU计算、Kubernetes、虚拟服务器、存储、网络服务等六大部分。

其中,Kubernetes提供了一个完全托管的,裸机无服务器的云服务基础设施,不仅为GPU加速的工作负载提供了最佳的性能,同时降低DevOps的开销。

作为英伟达第一家计算精英云解决方案提供商,CoreWeave可以在云中访问十多个Nvidia GPU SKU,包括H100、A100、A40和RTX A6000,除此Coreweave还提供了全球最大的NVIDIA HGX H100 GPU集群,每个GPU拥有40GB的HBM2内存。

而新的融资也将用于购买更多的GPU,以及投资数据中心。当下,CoreWeave的首要任务就是加倍努力建设人工智能基础设施,并积极开拓此领域的新客户,由DeepMind联合创始人Mustafa Suleyman领导的初创公司Inflection AI就是其中之一。CoreWeave联合Nvidia和Inflection AI共同构建一个拥有22,000个Nvidia H100 GPU的AI训练集群,据称这是世界上最大的AI训练集群之一。

CoreWeave为生成式AI、大型语言模型和AI工厂提供加速计算基础设施的战略将有助于为每个行业带来最高性能、最节能的计算平台。

谁控制了英伟达的芯片,谁就控制住AI未来的发展,至今为止这绝非虚言。要知道对于大模型“世界”来说,算法就是“生产关系”,算力是“生产力”,数据是“生产资料”。究竟是人工智能,还是“人工智障”,算力就是让大模型运作起来的前提要求。而目前制约AI发展的一大困境就是算力还不够充足。

现在,有一家被称为“算力黄牛”的公司——CoreWeave,手中掌握了成千上万块英伟达的AI“算卡”,还出其不意,将英伟达芯片作为抵押物,成功完成23亿美元债务融资,估值在四年内飙升至80亿美元。

这家AI云计算新秀究竟是如何在谷歌、微软等巨头的竞争中开辟出自己的一片天地呢?

成立于2017年的CoreWeave有三位联合创始人,他们背景大部分来自跨产业的实践,但共性特点是对金融产品的敏锐洞察。

首先,Michael Intrator,作为CoreWeave的首席执行官,负责公司的所有运营工作。在加入CoreWeave之前,Michael Intrator是Hudson Ridge Asset Management(该公司押注天然气期货)的联合创始人和首席执行官。

其次,Brian Venturo,CoreWeave的联合创始人兼首席技术官。在加入CoreWeave之前,他花了十多年的时间建立和运营专注于能源市场的对冲基金。

其后,Brannin McBee作为CoreWeave公司的联合创始人和首席战略官,在云计算和数据分析方面拥有非常专业的知识,为计算密集型应用场景提供专业且可扩展的解决方案。

据Brian Venturo回忆,在2016年他们购买第一个GPU,并在以太坊网络上挖出了第一个区块,自此便踏入了Web3挖矿行业,并在2017年成功将副业转变为公司运营。

CoreWeave最初作为一家针对以太坊的挖矿公司,他们的生产资料就是GPU,在2018年底就已部署超过50000个GPU,占据以太坊网络算力的1%以上,成为北美最大的以太坊矿工。

随着市场竞争逐渐激烈,同时受限于电力价格影响,他们意识到在挖矿领域的优势后续可能会逐渐消失,于是他们决定发展其他领域,开始多元化经营,找准了公司未来的发展方向,实现转型。

由此观察,算力芯片真的成为了从挖矿到人工智能领域的数字“石油”。

从2019年起,CoreWeave开始专注于购买企业级GPU芯片组,构建专门的云基础设施,围绕英伟达的芯片调整业务。

乘着AI发展的大浪潮,CoreWeave依托英伟达显卡成为云计算服务公司,拿下微软、谷歌等大客户,一举进入独角兽行列,成为目前全球最大的独立GPU云提供商之一,为VFX、人工智能、游戏和医疗等各行各业的客户提供服务。

CoreWeave迎来了自己发展历程中的辉煌时刻,事实证明转型这个决定是正确且幸运的,在大环境的洪流之中,这家初创公司抓住了不断膨胀的AI市场需求。

在英伟达H100十分紧缺的情况下,CoreWeave还是分配到了大量新卡,并且该公司也是全球首批使用英伟达最新HGX H10芯片的云服务商之一。就是这样,CoreWeave通过不断创新和优化,“抱紧英伟达的大腿”。

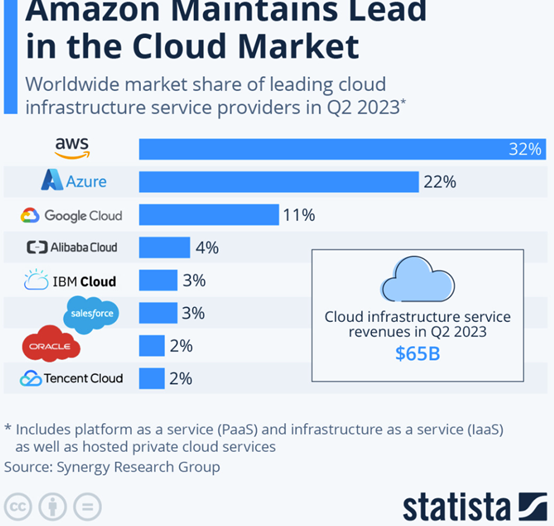

从整个云计算竞争市场来看,谷歌、亚马逊和微软依然占据大部分市场份额,根据Statista 2023年第二季度数据报告,Amazon、Microsoft和Google等8家云服务商控制了市场的80%份额。其中,AWS去年收入达到801亿美元,谷歌云和Azure收入也远远超出了CoreWeave的估值。

英伟达的“AI云”野心逐步显现,此前亚马逊、微软、谷歌三大巨头牢牢把控着云计算市场,要想分一杯羹并不容易。

根据Statista数据,2022年亚马逊AWS的市场份额为32%,微软Azure为22%,谷歌云为11%,三家合计市场份额达到了65%。

有分析解释称,云服务的本质是将数据中心内的硬件资源虚拟化,然后租给市场。传统数据中心的服务器几乎100%是基于英特尔、AMD的CPU建设的,但CPU并不擅长大规模的数据处理与并行计算,而英伟达GPU正可以弥补CPU在这方面的短板。

今年3月GTC大会上,英伟达正式发布NVIDIA DGX Cloud人工智能云服务,并宣布与多家云服务供应商合作,使得企业无需采购和拥有服务器,便可通过云服务商合作托管的DGX Cloud基础设施。

但英伟达的选择不是毫无风险的:一边是激烈的同行竞争,众多公司争相入局AI赛道,努力抓住发展机遇;另一边,这种直接向大公司和政府销售AI服务的新商业模式,可能使英伟达与作为其最大客户的大型科技公司发生冲突。

人工智能技术的蓬勃发展加速了市场对算力基础设施的需求,对于投资者来说,生成式人工智能仍然是一个很大的亮点。根据PitchBook的数据,2023年第一季度,生成式人工智能初创企业在46笔交易中获得了约17亿美元的收益。

在当今的人工智能竞赛中,率先进入市场至关重要。而CoreWeave致力于帮助公司获得快速进入市场所需的计算资源,专为计算密集型工作负载打造解决方案,这使其成为那些急于将产品推向市场的人工智能初创公司的一个绝佳之选。

CoreWeave首席执行官兼联合创始人Mike Intrator表示,“我们知道人工智能算力需求即将爆炸式增长,所以我们做了数年时间的准备工作以应对这一刻。”正所谓“十年磨一剑”,在这场关于AI算力的争霸赛中,CoreWeave似乎已胜券在握。

再回看今年英伟达发布的DGX Cloud,就是此前发布的超级计算机的云版本,一个DGX Cloud实例(云服务器中的虚拟计算机)配置了8张A100或H100。然而,DGX Cloud的售价并不便宜,每个月36999美元,大约26.4万人民币。作为对比,含有8颗A100的微软Azure ND96asr实例与其同等规格,每个月费用为19854美元,只有DGX Cloud的一半。

为什么英伟达敢定如此高的价格?答案在于DGX Cloud是一款集成了软件与硬件的交钥匙解决方案。英伟达现在已经不再标榜自己是一家GPU芯片公司,而是定位一家计算平台公司。

DGX Cloud除了硬件资源,还推出了两个配套软件平台,一是NVIDIA AI Foundations,帮助企业创建定制模型,包括语言、视觉与生物医药模型等;二是NVIDIA AI Enterprise,它包含了4000个不同的AI框架,帮助企业开箱即用。英伟达的AI产品与国内阿里云等云服务商推出的MaaS类似。

由此可见,英伟达经过一系列动作,通过实现自己生产产品GPU的金融属性,不仅保障营收方面扎实稳健的增长,同时,对于多元化销售方式和供应链把控方面,逐步显现出“链主”地位,从基础的经营层面和多元化资本结构层面对于AI带来的产业机遇进行牢牢掌控的布局。